一、相关名词

大数据与抽样小数据的融合,是一个非常前沿的题目,从数据到理论,我们一直在追踪。其实在全世界范围内,这个题目都还处于研究的起步阶段。首先,我先界定一些名词,这部分名词有些大家熟悉,有些可能有一定的技术含量,还有一些在学术界使用的与业界平时熟悉的有所差异,同时因为很多的概念都是从英文文献翻译过来的,不同译者的翻译有所不同,所以需要界定一下。

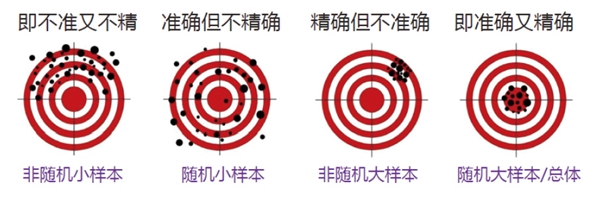

背景(Demographics)、动机(Motivations)、行为(Behavior),这三个名词分别涉及到我们数据当中经常会使用的变量的总称。精确度和准确度,实际上是我们从学术界到电视业,到其他所有的科学技术、商业领域最关心的两个检验我们数据质量的指标。在英文中,学术界把它们叫做Validity和Reliability,有的学者把它们翻译成效度和信度,工业界或者是计算机专业,更习惯把它们称作Accuracy和Precision,就是准确度和精准度。最近这几年来,业界一直在使用的"精准",我想在此澄清一下其实"精准"是两个不同概念,即"精"和"准"。"精"和"准"最佳状态就是我们做的东西即准又精,但在很多时候"精"和"准"是一对矛盾,有了精没有准,有了准没有精,这个故事可能非常复杂,但是它非常重要。

同源数据(Uni-source)和异源数据(Multi-source)是数据融合中必须会面临的一对问题。同源数据是理想状态,异源数据则是我们每天面对的常态。同源数据的融合,英文叫Matching,我把它翻译成对接。异源数据的融合,英文叫Mapping,译作投射。到现在为止,对接是比较容易,谁都会做;而投射从理论到应用上都还没有很好解决的指导原则或操作方法。而这种悬而未决的问题自然成为前沿问题,为大家所关注。对接与投射的一个根本差别,就是计算机方法中讲的有监督学习和无监督学习之区别。简单的说,有监督的学习比较靠谱,无监督的学习是否靠谱无从验证。

二、总体、样本、大数据、小数据

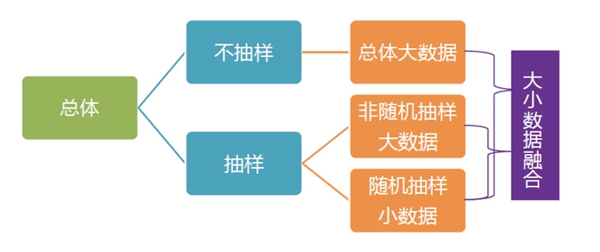

图1 关键词之定义

"总体",我们这里所关心的就是收看电视的观众,最理想的是以个人为计量单位的总体,有些应用层面是以家庭为总体,将来若干年后,我们的终端从大屏幕到手机和其他各种终端都实现双向连接以后,所涵盖的受众就是总体了,也就没有第二步的抽样了。但是这"若干年"究竟有多少年?三、五年,八年、十年,差不多就在这个区间里面,根据各个地区、各个国家对双向连接的政策和最初的技术制式等技术基础而决定。有的快一点,有的慢一点,但是我猜想大概十年之内都会实现,观众调查就没有抽样了,收集到的就是总体数据。大数据研究假定的数据是总体,所以很少谈抽样这个概念。但是实际上,至少在我们这个领域,电视收视率抽样还是常态。不通过抽样而直接获取总体大数据,这是理想状态,也许在某些中小城市或社区已经可以做到这一点,但是目前在中国大部分市场、大城市还没有得到收视率的总体数据,我们用的还都是样本。

样本其实有两类,按照样本抽取的方式,有随机的和非随机的,而随机的样本有大的和小的,非随机的又有大的和小的,因此从理论上讲应该分为这四种数据,即随机大数据、随机小数据、非随机大数据、非随机小数据。但是实际上现在见到的大数据,都不是随机抽样而得到的,而是非随机的,为什么?如果有一个总体数据,用随机抽样方法从中抽样的成本,比直接计算大数据更大,直接计算大数据无非就是数据多一点,需要更多的服务器,服务器需要更大的内存和硬盘而已,这些是可以通过经费来解决的。现在我们用的大数据,除了总体数据以外都是抽样而得到的,而且这些抽样的方法都是非随机的。例如从智能电视上得到的数据,即使智能电视用户是几千万,但不是每个家庭都有智能电视,就算买了智能电视的家庭带有一年的免费的订阅服务,但还有相当一批家庭有了这样的服务也不用。例如在香港,现在市场上很难买到非智能的电视机,智能电视入户的比例非常高,其中一半家庭将智能电视机接上了互联网,而其他家庭买了智能电视机还是当作非智能电视机来用,这样你得到的只是总体中三分之一家庭的智能电视收视数据,而且还是一个非随机的样本。我们现在讲的小样本就是入户调查、电话调查方法得到的,基本上都是随机的。如果样本量小,再是非随机,这样的样本基本上是没有意义的。不是很正规的小的市场公司,甚至包括学术界的一些学生做的研究,基本上都是非随机的小样本,应用意义不大。电视收视率这样有几十年历史的行业,用的都是随机小样本。实际上业界讲的大小数据的融合就是两类大数据,一类是总体大数据,这是例外,一类就是我们见得比较多的,是非随机抽样的大数据和我们随机抽样的小数据之间的融合。

三、核心变量

变量(Variable),就是一个数据里面所含有的信息,变量是一个统计学的概念。以数据库为例,其中每一个数据表是一个矩阵方,每一行代表一个个人或者家庭,每一列代表一个信息特征,用统计学的术语来讲就是一个变量。我把收视率相关的变量划分为三类。

第一类是背景。包括性别、年龄、职业、家庭收入、居住地点等,这类数据与电视收视率相关,这类数据只能从小样本当中获得。除非将来所有的终端都双向接入,而且有国家政策,所有的终端都必须实名登记,年龄、性别、居住信息等都可以从终端总体数据获得,即便如此,收入、文化、种族背景、宗教信仰等信息还得通过小样本调查而获得。

第二类是动机变量。动机变量这个名词其实有点窄义,我把英文里兴趣、爱好、期望,甚至理解能力、记忆力等变量都归为动机。前面提到的年龄、性别等都是与生俱来的,或者是个人长期固定的,看得见摸得着,因此称其为背景;动机是与这个人、或这个家庭相关的,虽热看不见摸不着、但确实存在,而且对收视行为和购买行为有很大影响,我统称为动机变量。这一类数据,只能说是相对靠谱,是从小样本的调查当中,通过一些直接或者间接相关的问题,然后从调查数据背后来挖掘的。

在大数据时代,越来越多的是从第三类变量(即行为变量)中挖掘。行为变量就是收视率行为,什么时间、什么人、在什么地方、收看了哪个频道?然后再根据跟这个频道对应的节目单,不仅能知道看了什么频道,还可以了解看了什么内容。从这种初步数据中,又可以挖掘很多进一步的信息。收视率的数据其实就是一个行为变量,但你可以从中构建出几十个甚至几百个概念。最基本的有收视率、占有率、到达率、忠诚度等,还可以进一步产生几十个甚至几百个衍生产品出来,这就是我们收视率行业的魅力和挑战。

总之,这三类变量中,背景和动机主要来自小样本,行为来自于大样本或总体数据。

四、评估数据质量的核心指标

无论大、小样本数据,我们都关心其质量如何,电视台、广告客户,甚至管理部门、社会大众都关心质量问题。但质量不是用一句话或者一个指标就能厘清好坏的,至少要从三个维度进行考量。

第一个维度是信息量(Informativeness),即变量的个数。一般而言,变量数量越多,信息越丰富。收视率大数据的信息多吗?不多,往往就只有一列(Column,即变量数),如每一个人在什么时间什么地理位置收看哪一个频道。如果你用的是移动终端,那就加上地理位置信息,但是总的来说大数据的变量个数是非常少的。真正接触大数据的人都知道,大数据其实多的是行(Row,即个案数)。例如原来用调查方法,一个样本有几千人,那么得到数据只有几千行,现在是服务器数据,几千万人、亿万条的记录,而且以前做日记卡调查每个时间单位是15分钟,现在是以毫秒单位在统计的,所以几千万人每天的记录是几十个TB,几十个PB等等,大家不需要去计较到底有多少条记录,反正是10的几十次方这么一个数字。搞工程技术的人讲信息量讲的是条数,而不是列数。而我们需要的信息没有那么丰富。我写了一篇文章《一个文科教授眼中的大数据》,讲了其中的区别,看过的人大多会同意现在的大数据信息量其实并不多。

第二个维度是准确度(Accuracy)。准确度讲信息反映的事情是对或者错,其实科学家们不喜欢讲这个字,因为对和错好像带有价值判断,换言之,就是说的这个事情是不是真的。以收视率为例,它告诉我们,总体即全国人民中有多少在看这个节目。但一直存疑的是,人员测量仪测到电视机开着,是否等于人在看电视,这就是一个准确度的问题。如果有人开着电视,却跟别人聊天讲话、看手机、上洗手间、去厨房干活等等,一般的回答是假定这种行为都是随机的,从总体上讲也许有个20%—30%的人不在看电视,如果这是一个稳定的数字,白天到晚上,播电视剧跟新闻,都是这个规模,那我们就可以把它当作是准确度里面的一个随机误差。准确度这个数字是很重要。

第三个维度是精确度(Precision)。小样本是抽样的,拿抽样的数据去预测总体,一定会有误差。例如,美国总统大选期间,每天都有爆炸性的新闻发生,这些事件对选举结果都有所影响,当选的可能性一直在变。但是大部分的调查都会报告我这个调查的抽样误差是3%,假定现在有一个预测说希拉里会以51%的支持率击败川普49%的支持率,差2%,但是抽样误差是3%,这能说明什么呢? 这个2%的差别是在这个样本里的,在总体里面他们两个人的差别,希拉里可能最高得54%,最低是48%,那么川普也可以从49%+3%变成52%。所以实际上在总体当中他们两人旗鼓相当,难解难分,并没有定论,这就是精确度。精确度可以计算,精确度与样本大小有关,3%的精确度样本就是1000人左右,要提高精确度就需要不断增加样本,增加到1万,抽样误差在2%之内,增加到10万,抽样误差只有1%,增加到100万,抽样误差降到百分之零点几。到了千万级,你的抽样误差几乎可以忽略不计,到了总体数据精确度就是100%,抽样误差就是零。

最理想的状态是总体状态,就像打靶,每一个点就代表一次预测,总体样本就中间靶心十环的点,既准确又精确。但是如果我们用非随机的大样本,因为样本大所以很精确,各次的预测之间的差别很小,但是由于使用非随机样本,预测也许落在靶心,也许在靶的边上,甚至打飞了。问题在什么地方?问题在于我们不知道非随机的样本聚在什么地方、不知道它跟总体差多少?抽样调查以总统选举为例,因为可以事后验证,大体上还是准的,因为使用的方法是随机的小样本。就像图2中的第二个打靶,虽然看上去很乱,但是每一个点跟中心位置的差别平均下来,就是中心点。但非随机小样本完全不靠谱,既不精确又不准。

图2 几类样本的数据质量评估

我们现在面临的是什么?非随机小样本在业界不会出现,随机大样本/总体是理想状态,也实际上难以做到。所以我们面临的选择是随机小样本还是非随机的大样本,答案一定是随机小样本,它至少是准确的。确保了准确的前提下,如果还能与非随机的大样本结合起来,那就可以以小样本为基准来调整大样本,因为已经知道靶心在什么地方,再来比较非随机的大样本的偏差在什么地方,所以可以根据随机小样本的结果来调整非随机的大样本。倒过来(即从非随机大样本出发)不行,倒过来根本就没有基准。

五、大小数据之比较

简单地说,只要抽样方法是随机的,小样本相对来讲是准的。小样本有比较丰富的背景样本和动机样本,但是缺乏行为数据。而大样本和总体数据,行为数据非常丰富,但缺乏动机数据和背景数据,所以两者应该结合。其实大数据不是今天才有的。80年前的美国总统大选,有两家机构做预测,一家是《文学文摘》,发行量很大,通过期刊分发调查问卷,收回了230万份。另一是盖洛普,样本5万户。文学文摘预测的是共和党的兰顿以55%的领先当选,盖洛普的调查恰好相反。最后的选举结果是罗斯福当选,盖洛普的预测低估了5%,但大面上是对的,而那个230万的大样本则差了20%。问题出在什么地方?大样本是非随机的,根据杂志发行抽的,而杂志订阅人相对来讲是有钱的,有钱人当中共和党更多。这个例子在调查行业一直被反复引用,80年前就已经证明随机的小样本比非随机的大样本更好、更有用,因为随机的小样本代表的是准确,非随机的大样本代表的是精确,这两者当中准确比精确绝对重要。

六、数据融合的关键条件

数据的融合要满足某些条件,而且这些条件都与小数据有关。大数据或者总体数据可以是随机的,也可以是非随机的,但小数据必须符合下述条件。首先,小数据为随机抽样,以确保对总体的代表性(准确性)。其次,小数据的样本要足够大(数千人),以确保预测结果的精确度,太小的样本没用,小于一两千的误差太大,尤其对我们电视行业,频道与频道之间都是在零点几个百分点上竞争的,一千人的样本的误差就是3%,远远超过大部分频道所做的节目的收视率本身,所以样本要足够大,起码要有几千人。融合的第三个条件,小数据含有个人背景变量,其中动机资料是锦上添花,而背景资料是雪中送炭,一定要有,这样才能弥补大数据的不足,不然巧妇难为无米之炊。第四个条件,背景变量与行为变量高度相关,否则影响准确度,性别、年龄、教育、职业等变量要与行为变量的收视率、收视行为高度相关。我们一般用相关系数来代表,0代表没有相关关系,正1或者负1代表完全正相关或负相关。大部分情况下,背景资料与收视行为的相关系数在0.2至0.4这样的区间里,其实不能说是高度相关的,如果加上一些新的计算方法,各种其它数据的补充扩充,也许能够将相关系数提高到0.5、0.6之间。这就是现在融合大小数据的难点之一。大家在实际运用当中知道,年龄、性别等对人的行为预测是有限的。有些大数据专家讲92%、93%的行为都可以被预测,其实是指非常少数的特定情景,没有普遍意义。

七、大小数据的融合

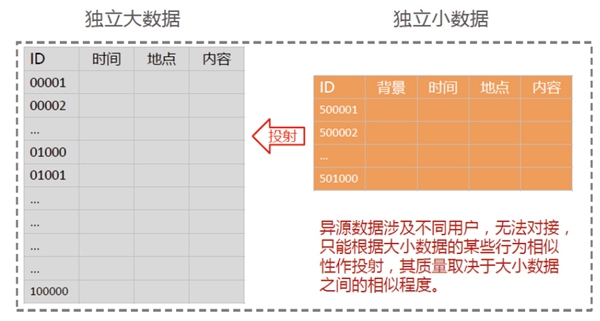

大小数据的融合分两类。同源数据,即大数据与小数据来自于相同的个体,那么只要根据共同ID对接,这比较容易,但非常少见;大部分情况是大数据跟小数据来自不同的人,是异源数据,没法直接对接,我们只能根据各种特征投射方法。

目前投射方法大体上的思路是寻找一至数个行为变量来替代个人ID、以作为融合大小数据的基准。具体说有三种基于行为变量的投射:第一种是根据相似的应用内容投射,因此小样本里一定要有行为变量,而刚才讲的同源数据之间对接是小样本不一定需要包含行为变量,可以直接把小样本的背景变量对接到大数据的行为变量数据上。但如果小样本是异源数据,小样本里面一定要有行为变量数据,否则无法根据应用内容来融合大小数据。第二种是根据相似的时间特征的投射,CSM的欢网数据就是按照时间特征来匹配(及地理位置)来匹配的;第三种根据相似的地理位置投射,这种方法的质量取决于地理位置的取值单位,越大(如街区、基站或更大范围)越不可靠,越小(如楼层甚至家庭)越可靠但也越难获取相关信息。

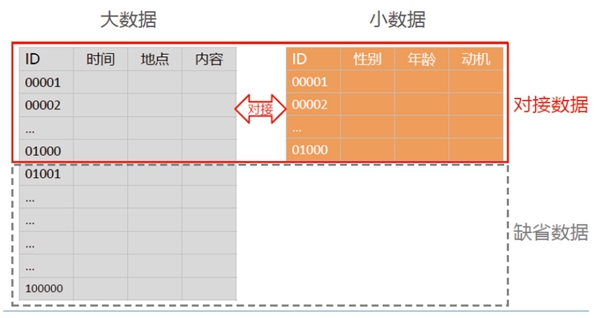

八、同源数据的合并

同源数据合并是很容易理解的过程,假定图3左边是大数据,有行为数据,时间、地点、内容都有,ID从1到无数大,每一个案有唯一编号。小数据是从调查得来的,也有同样的唯一编号,假定小样本是1000人,正好处在前1000,我们就直接根据ID把它们接起来。小数据下面部分是缺省的,缺省不是问题,我们是拿小样本作为种子把这些年龄、性别以及动机变量加到大数据当中去,然后根据这些变量计算他们的时间、地点、内容、性别、年龄等变量和动机变量的关系,之后再把上面一千人的关系推广(Extrapolate)到下面几万、几十万、几百万、几千万人当中,这种方法已经运用很多年了。

图3 同源数据的合并

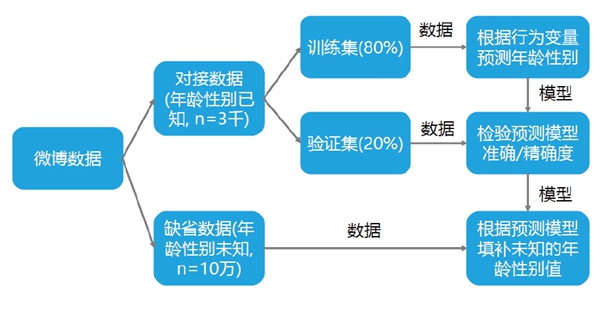

一个具体方法叫做同源数据有监督学习,就是小样本不能全部拿来做预测,而要保留一点作为检测数据。有监督是什么意思?假定有一个2000人的小样本,我用其中1600人来做学习,400人来做检验,这就是一个有监督的学习过程。社会科学研究通常不讲究这最后一步,但在数据挖掘等技术领域中则普遍使用。我们觉得这个方法更严谨、更科学。步骤主要如下:第一步合并同源数据,按大小数据中共有的ID对接数据,其中部分不能对接的个案为缺省数据,是数据融合中需要解决的一个核心核心问题。第二步是训练预测模型,从对接数据中随机抽出80%左右作为训练集,估算已知行为变量与背景变量之间的关系,建立一个用行为预测背景(注意:这与一般从背景预测行为的研究相反)的模型。第三步是验证预测模型,在对接数据余下20%左右个案中,根据预测模型,从行为变量推算背景变量的值,并与其实际值相比,从而算出预测的准确度与精确度。最后应用预测模型,将验证后的模型应用到缺省数据,从行为变量预测未知的背景变量,把一千人的关系推广到剩下的几十万、几百万、几千万人当中。

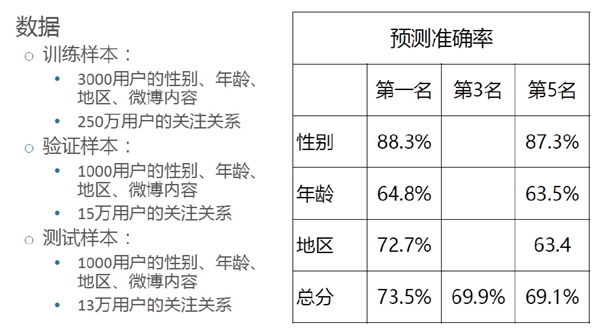

举个例子,最近我们参与了一个全国微博数据竞赛,小样本有3000人,大样本除了这3000人以外还有几十万人。把小样本按八二分或者九一、或者七三分,不要对分,因为训练样本的数据要多,训练出来的内容丰富、稳定,而检验的样本相对小。训练之后检验,检验之后应用,就是这样的过程。数据中保留一部分的验证集来检验模型的精确度和准确度,然后推广到大数据。竞赛主办方公开提供了3000人的数据作为训练和验证,它自己还保留了一个测试集,来评估最后的结果。参赛者事先并不知道最终测试集的结果,所以就像预测选举和股市一样,主办方保留的数据是最后的审判者。

图4 根据微博行为预测用户年龄与性别

图5是竞赛前几名的成绩。左边是数据结构,要预测性别、年龄和所在地区,这些数据在微博里有部分用户自己填写的,也有大量的用户是未知的,希望用竞赛结果去补充。相比之下,性别是最容易判断的,因为只有两种可能,男和女,不用任何学习方法,就有50%的准确率,加上各种微博内容提供的信息,所以预测较准,第一名是88%,第五名是87%,很接近。国际上的一些大赛要求参赛方提交5位小数的结果,就是因为胜负要靠百分数后面的三位才能决定。年龄的可能性比较多,所以相对来讲误差大一点,准确率在70%上下。在同源数据融合中,这已经是很好的结果了。大小数据融合不可能像根据DNA克隆那样做到99.99%的准确率。

图5 2016年某微博竞赛测评结果

九、异源数据的合并

异源的数据是更经常见到的。两组数据来自完全不同的人,所以没法对接,只能投射。投射时,这两个数据是独立的,从步骤上看上去好像也经过三步,但我们没法加以验证,因为不是来自同样的人,没有办法知道真相。

图6 异源数据的合并

例如,我们曾根据欧洲某市场手机行为变量投射用户背景变量。从步骤上看,与同源数据的有监督学习相似,但因两个数据不是直接对接,而无法保证将小数据的预测模型投射到独立大数据的质量。我们采用了决策树方法,根据行为数据中的地点、内容、时间段三个基本的信息,预测年龄、性别,然后根据这些背景变量再来反过去解释其他行为变量。这个过程是投射,而不是对接。我们用决策树方法能够看出什么行为变量在哪一阶段能够区分用户人群。比如,只需要知道时间就能把退休的、无业的人与其他的人分开,因为无业的人不需要上班,所以他们没有特定的规律;而知道了地理位置,还要配上他们在不同地点上的手机应用,就知道他们是中年还是白领组;配上内容就可以知道他们是男性还是女性;如果根据内容与地理的配合,就找出年轻人来;或者用其他的内容找出男性人群、等等。这是一个基本思路。

如果小数据里没有行为数据,那么基本上是巧妇难为无米之炊,大小数据之间的个案或变量如果没有任何交集,两者无法融合。剩下所能做的是用各种无监督学习方法(如聚类分析、网络分析等),在大数据中做用户画像。但是画像的准确性是没法证明的。我们可以用各种办法勾画出很多人群,这些人群到底在真实生活当中是否存在,这个问题是没有标准的,准确度绝对是有问题的。

十、结语

大小数据各有其强弱之处,所以应该融合互补。理想状态的融合是同源数据,其融合质量不一定好,但是其精准程度可以通过有监督学习方法而估算。异源数据更常见,能否融合取决于小样本有无与大样本交集的行为特征(如时间、地点、内容等),其融合质量则取决于两个数据的相似度。如异源数据之间没有任何交集变量,则巧妇难为无米之炊,只能在大数据中做无监督学习的用户画像,但其真实性(准确度)无法检验。可见,数据融合的关键在于以下条件:其一、小数据是否随机产生;其二、样本是否足够大(数千以上为佳);其三、是否含有一至数个行为变量;其四行为与背景变量是否高度相关。

All rights reserved © 2011-2023 CSM Media Research 京ICP备05047992号-5

京公网安备 11010502035133号 法律声明诚聘英才联系我们隐私保护